No discurso, as big techs refutam a ideia de que são moderadoras de conteúdo, mas na prática, tomam decisões sobre a circulação de informações baseadas em processos pouco transparentes. A avaliação é da pesquisadora de regulação de mídia Beatriz Barbosa, mestre em políticas públicas e integrante da organização Intervozes.

Ela é uma das autoras do recém-publicado estudo “Fake News, como as plataformas enfrentam a desinformação”, que analisa políticas contra notícias falsas de Facebook, Instagram, WhatsApp, Youtube e Twitter desde 2018.

A pesquisa considera uma série de avanços, mas conclui que todas as plataformas esbarram no mesmo problema: não têm política estruturada sobre desinformação, o que resulta em decisões unilaterais e pouco claras sobre a remoção de conteúdos.

Para a pesquisadora, as big techs não devem mesmo assumir o papel de editoras de conteúdo, mas ao reduzirem o alcance de publicações, assumem essa figura. Deveriam, portanto, apresentar diretrizes robustas sobre desinformação e considerar o tema em relatórios de transparência.

“Como essa política não está estruturada do mesmo jeito em que estão as políticas sobre conteúdo de ódio, violento e danoso, a desinformação não aparece nos relatórios”, diz. Isso é um problema porque, segundo ela, fica difícil medir a eficácia do que é feito pelas plataformas.

A maior crítica do estudo é que as ações contra as notícias falsas estão desorganizadas nos termos de uso. Mesmo os usuários e pesquisadores que se dedicam a ler as extensas políticas das redes sociais, têm dificuldade de entender o que vale e o que não vale nesse aspecto.

Pode falar um pouco sobre a pesquisa e em que contexto ela iniciou? Começamos a em abril, mas retroagimos até 2018 porque a maneira com que as plataformas lidam com a desinformação muda muito e não está consolidada nas políticas, nos chamados termos de uso ou padrões de comunidade. Elas lidam de forma reativa e mudam conforme surgem denúncias.

Tais medidas estão dispersas em textos de blogs oficiais das plataformas. Parte significativa da pesquisa foi varrer esses blogs para compilarmos o que está em vigor. Sem isso, não seria possível fazer qualquer análise, e isso é um problema de transparência.

Por quê? Primeiro porque o usuário não sabe o que pode e o que não pode fazer na plataforma em relação à desinformação. Segundo porque não sabe o tipo de medida que a plataforma vai adotar contra um conteúdo. Terceiro porque, como essa política não está estruturada do mesmo jeito que estão as políticas sobre conteúdo de ódio, violento e danoso, a desinformação não aparece em relatórios de transparência. Não há como medir a eficácia, não temos dados para verificar se o que as redes dizem que estão fazendo, estão fazendo de fato.

Quais foram as principais medidas contra a desinformação anunciadas desde 2018? Em geral, as cinco plataformas optam por não remover conteúdo desinformativo. Algumas reduzem o alcance de posts e todas têm a opção de disponibilizar o que chamam de informação de contexto, que é informação adicional sobre determinado tema que está vinculado à postagem.

Só que com a chegada da Covid-19, várias medidas foram adotadas, também como reação. Surgiram muitos conteúdos desinformativos sobre cura, tratamento, isolamento social, e as redes sociais passaram a responder, sim, com remoção.

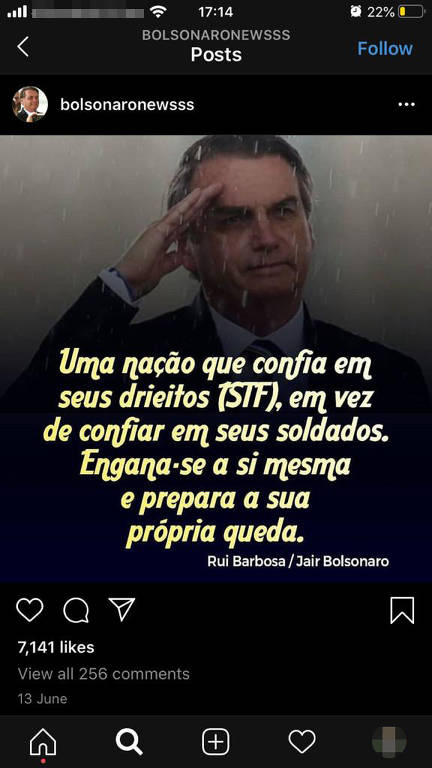

Foi o caso da exclusão de posts de Trump e de Bolsonaro, por exemplo. Excluíram de Bolsonaro e de Trump, mas o YouTube também removeu vídeos que falavam sobre cura da doença. As redes também removem nas eleições, somente durante o período eleitoral; são posts que podem enganar o eleitor sobre o pleito, com informações falsas sobre local e data de votação, por exemplo. Foi o que aconteceu com as postagens de Trump questionando a validade da segurança da votação por correio nos Estados Unidos.

Em eleições e na Covid, as plataformas avaliam que há um risco de dano para usuário. Nos parece que, diante da gravidade dessas questões, faz sentido fazerem a remoção.

Qual a crítica, então, em relação a essa medida? O problema é que essa remoção não é seguida daquilo que chamamos de “devido processo” na moderação de conteúdo. Uma parte dos usuários, por exemplo, não é notificada se seu post teve alcance reduzido, se foi removido. Não há uma política de contestação quando um post é caracterizado como desinformativo.

Como nosso estudo olha qualitativamente as medidas das plataformas à luz de recomendações internacionais e de organismos como relatorias da ONU e da OEA para liberdade de expressão, não ter o devido processo é um risco para liberdade de expressão. Fica para as empresas definirem o que será removido. Mesmo quando há parceria com as agências de checagem e elas veem que a informação é falsa e o alcance da postagem é reduzido, essa redução pode significar quase uma invisibilização do conteúdo na rede.

Quando combinamos isso a nenhuma transparência sobre o impacto dessas medidas de moderação, de quantos conteúdos foram atingidos e tiveram alcance reduzido, vivemos um quadro de risco à liberdade de expressão.

As redes sociais fizeram parceria com o TSE para combater notícia falsa nestas eleições. Qual a sua avaliação? Sem dúvida é uma parceria importante, ter um canal direto de comunicação entre o TSE e as plataformas para a troca de informações. Mas o que vemos, infelizmente, é que o foco da preocupação do TSE com a desinformação se restringe às fake news sobre processo eleitoral, ou seja, sobre as urnas, sobre os locais de votação, datas ou medidas sanitárias na hora de votar.

Mas não é também sensível ao TSE intermediar muito as publicações? De maneira nenhuma achamos que deve haver salvo-conduto dado pelo TSE para as plataformas removerem conteúdo. O TSE tem que orientar juízes eleitorais e tribunais regionais eleitorais para que o enfrentamento à desinformação seja feito, inclusive, com base na legislação já em vigor, como o Código Penal, quando fala em calúnia, injúria, e com legislações relacionadas a racismo, preconceito. O Brasil tem normativas que podem ser aplicadas para deliberar de modo a garantir o devido processo e retirar do ar conteúdos com ordem judicial.

Então entende que a postura do TSE deveria ser mais proativa? O que ele poderia fazer de diferente? Na nossa avaliação, o TSE deveria ter formado e preparado os atores do processo eleitoral, tanto o Ministério Público Eleitoral quanto a Justiça Eleitoral, para que a resposta a eventuais denúncias feitas pelas candidaturas nos 5.500 municípios do Brasil fosse célere e efetiva na remoção. Vimos em 2018 uma série de decisões do TSE acontecendo de maneira que não respondia à velocidade do pleito.

Pode dar exemplos? A história do chamado kit gay, por exemplo, foi uma fake news muito famosa em 2018. Mesmo após decisão do TSE dizendo que aquele conteúdo era falso e que deveria ser removido, ele continuou sendo utilizado por campanhas eleitorais até no rádio e na TV. O TSE poderia dar respostas céleres também a empresas que fazem disparo em massa no WhatsApp.

Eles lançaram uma ferramenta em parceria com o WhatsApp na qual o usuário denuncia disparos em massa. É fundamental o cidadão participar desse processo e ser fiscal de um pleito limpo e democrático, mas ao só contar com o eleitor, a chance de as medidas não serem efetivas é muito grande. O Ministério Público de São Paulo entrou com abertura de inquérito para avaliar as denúncias feitas pela Folha que mostram que as empresas de disparo continuam operando. Essa denúncia tem mais de um mês e até agora não temos decisão.

Você menciona uma “política estruturada” contra desinformação. Se as plataformas não querem ser árbitras, como seriam essas políticas? A política estruturada significa a plataforma ter um lugar em que estabelece regras de funcionamento do seu serviço, tópicos dizendo como lida com a desinformação, e isso não aparece, não está organizado dessa forma.

Quando você entra no Facebook e quer saber como ele lida com discurso de ódio, tem uma política extensa. O YouTube tem exemplos de conteúdos bem detalhados do que pode e o que não pode. Em relação à desinformação, não estão estruturadas dessa maneira, embora elas moderem conteúdo.

Na prática, as plataformas negam o fenômeno da desinformação enquanto algo presente. O problema precisa ser reconhecido, comunicado a usuários e enfrentado com medidas sistematizadas.

Depois de três, quatro anos em que esse fenômeno ameaça as democracias, as plataformas lidam de forma quase a negá-lo, porque só reagem a questões mais sérias, se recusando a lidar com esse problema de maneira sistemática e estruturada.

Raio-X

Beatriz Barbosa, 43

É especialista em direitos humanos pela USP, mestre em políticas públicas pela FGV e pesquisadora da área de regulação da mídia. É integrante do Intervozes e do CGI (Comitê Gestor da Internet)

Comentários

Os comentários não representam a opinião do jornal; a responsabilidade é do autor da mensagem.