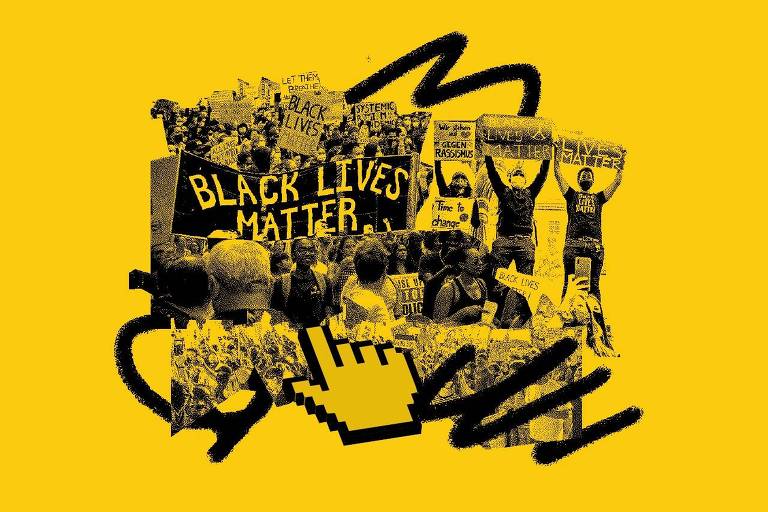

Há pelo menos dois anos, a Meta (ex-Facebook) discute como evitar a normalização do racismo e melhorar a experiência de pessoas negras na rede social, mas a adoção de uma política efetiva só foi acelerada após o assassinato de George Floyd nos Estados Unidos e o movimento #BlackLivesMatter ganhar projeção global.

Até novembro deste ano, quando a empresa anunciou que irá mensurar dados raciais, mudanças estruturais da política da plataforma esbarraram na ausência de dados e na falta de ações efetivas para dar apoio a minorias, de acordo com relatos de funcionários registrados em documentos internos de 2020 e 2021.

Os relatórios estão nos chamados Facebook Papers, documentos internos enviados à Comissão de Valores Mobiliários dos Estados Unidos (SEC, na sigla em inglês) e fornecidos ao Congresso americano de forma editada, com ocultação de nomes, pelos advogados de Frances Haugen, ex-funcionária da Meta.

A Folha faz parte do consórcio de veículos de mídia que teve acesso a esses papéis e analisou os documentos de política racial em parceria com o Núcleo Jornalismo.

Americanos negros estão entre os grupos com maior engajamento na rede social. Em 2019, conforme mostra uma pesquisa interna da própria companhia, a rede social detectou que vídeos virais nocivos, como de brutalidade policial, geram impacto até na vida offline de usuários negros.

O estudo destaca que "vídeos policiais foram uma fonte constante de estresse aos participantes negros", que chegam a alterar o comportamento fora das redes. A polícia da cidade de Memphis já usou perfis falsos para monitorar ativistas negros, diz o relatório.

O problema também passa por discriminação algorítmica, um desafio a várias companhias de tecnologia.

Em setembro, por exemplo, alguns usuários da rede foram questionados se queriam "continuar a ver vídeos sobre primatas" —o rótulo estava vinculado a um vídeo de um homem negro. O sistema de inteligência artificial de recomendação, primeiramente programado por pessoas, associou características daquela imagem a uma pessoa negra.

"Nossas equipes trabalham todos os dias para melhorar as experiências das comunidades marginalizadas que usam o Instagram e o Facebook", disse a Meta, em nota. O grupo destaca que avaliou possíveis implicações de direitos civis em novos produtos, segundo consta em recente relatório.

Tanto a discriminação por algoritmos —enviesados pelo imaginário de quem os programa— quanto a exposição de negros a conteúdos de baixa qualidade eram tópicos recorrentes de discussão nos últimos anos. No entanto, o tema só torna uma urgência depois do levante antirracista nos Estados Unidos, de acordo com os documentos divulgados.

Dias após o assassinato de Floyd, um funcionário sugeriu o acompanhamento de qualquer "impacto desproporcional" para usuários negros, mostra um relatório. A partir daí, iniciou-se uma série de discussões sobre como criar uma política de justiça racial para que a empresa não ajudasse a perpetuar o racismo sistêmico.

Um dos obstáculos para o Facebook, citado em uma série de documentos, era a falta de estatística sobre negros para criar políticas. A rede social não capta intencionalmente dados de raça dos usuários, o que dificultaria, segundo empregados, uma mensuração.

"Enquanto presumidamente não temos uma política pensada para colocar minorias em desvantagem, definitivamente temos políticas, práticas e comportamentos emergentes que fazem isso", diz um funcionário no post de um grupo chamado Ideias de Integridade Para Combater Injustiça Racial. Ele teve o nome ocultado pela assessoria jurídica de Haugen.

"Devemos estudar de forma abrangente como nossas decisões e como a mecânica da mídia social apoia ou não as comunidades minoritárias", afirma.

Embora sistemas de aprendizado de máquina consigam, implicitamente, adivinhar a raça de muitos usuários, conforme destacou um interlocutor no mesmo documento, a falta de mensuração direta sobre negros passou a se impor como o objetivo a ser perseguido pela empresa para a criação de uma política.

"Uma visão mais cínica é que parte do motivo pelo qual evitamos medir a raça é porque não queremos saber o que nossa plataforma está realmente fazendo —particularmente no Facebook. Se você não pode medir, não pode agir", diz um empregado.

Cogitou-se a criação de um "oversight board" (como é chamado o conselho externo que julga publicações que ficam na área duvidosa das políticas de uso e remoção) interno, composto por empregados de todos os lugares do mundo que se portaria como uma "voz oficial nas deliberações de pequenos grupos".

Em setembro de 2020, um documento intitulado "Permitindo Medição de Justiça Social com CEPs dos EUA" foi divulgado internamente sugerindo métricas para identificação de negros sem invadir a privacidade dos usuários. Trata-se da primeira medida mais prática relacionada a algoritmos.

A ideia era cruzar códigos postais dos Estados Unidos e dados do censo americano (como o IBGE no Brasil) para poder medir seus produtos por raça e etnia nos bairros correspondentes.

Para Paulo Rená, ativista no Aqualtune Lab e professor universitário, uma inferência matemática sobre uma pessoa que mora em determinado bairro, tem determinada renda e sobrenome pode ser uma alternativa bem-vinda, desde que considere nuances.

"Temos que ter cuidado com essas inferências, porque se eu tenho uma média que diz que 90% de pessoas num grupo são de um jeito, isso não determina que aquela pessoa que eu estou analisando vai estar naqueles 90% e não nos 10%", avalia.

Quase um ano depois, em novembro deste ano, a Meta divulgou que enfim irá cruzar esses dados para usar de modo estatístico na plataforma, o que indica um passo para uma política racial. Diz que consultou mais de duas dúzias de especialistas em privacidade e direito civil para definir um método não invasivo e personificável.

Para o pesquisador indiano Ramesh Srinivasan, doutor em Harvard e fundador do Laboratório de Cultura Digital da UCLA, na Califórnia, uma solução eficiente é compartilhar o poder de moderação da plataforma.

Ele diz que o Facebook não pode se portar como uma espécie de caixa-preta de tecnologia.

"Não precisa publicar seu código-fonte, mas precisa realmente ceder o poder de moderação de conteúdo para muitas organizações diferentes que tenham a expertise para entender questões raciais, questões de gênero, questões trans queer e também questões geográficas", sugere.

OUTRO LADO

Procurada, a Meta afirma que "está em constante evolução com base nas questões que encontramos em nossas plataformas e no feedback que recebemos da comunidade". Diz que divulgou em novembro um relatório detalhando seus avanços em relação a uma auditoria de direitos civis realizada em 2020.

"O relatório destaca o nosso trabalho para desenvolver um processo de revisão para as equipes de produto, no qual avaliamos as possíveis implicações de direitos civis em novos produtos. Uma parte essencial desse esforço é nosso trabalho em conjunto com especialistas em direitos civis. Para nós, é essencial que todas as comunidades tenham experiências positivas e seguras em nossas plataformas, e continuaremos trabalhando para atingir esse objetivo", destaca a empresa.

Comentários

Os comentários não representam a opinião do jornal; a responsabilidade é do autor da mensagem.