Grandes modelos de inteligência artificial tendem a contar mentiras, e fazer isso de forma convicta, quando não tiveram contato com informação suficiente sobre um assunto.

O comportamento, chamado de alucinação, é a principal barreira para aplicação da tecnologia em tarefas delicadas, por exemplo, nos consultórios médicos e nos tribunais, segundo artigo publicado na revista Nature.

Esse mesmo artigo propõe uma solução que provou ser mais eficiente do que a checagem humana: usar outros dois modelos de IA para identificar o risco de a primeira plataforma gerar várias respostas com significados diferentes para a mesma pergunta.

É o caso, por exemplo, da pergunta "onde está a torre Eiffel?" As IAs testadas responderam coisas como "é Paris", "a capital da França ", "Roma" e "Berlim". Nessas quatro respostas, há três significados diferentes, o que aponta a confusão do modelo de inteligência artificial.

O autor do estudo, o pesquisador da Universidade de Oxford Sebastian Farquhar, definiu essa situação como "estado de alta entropia semântica", ao emprestar da física o conceito de "nível de entropia" —uma medida do quanto um sistema está caótico.

Essa medida acabou mostrando alta relação com a probabilidade da inteligência artificial alucinar —ou confabular, como diz o estudo.

"O grande desafio foi distinguir inconsistência de significado de inconsistência na escolha de palavras", escreveu Farquhar na rede social X. A solução foi agrupar as respostas que tinham o mesmo significado, mesmo que tivessem diferenças lexicais e sintáticas.

No caso das respostas sobre a torre Eiffel, "Paris" e "capital da França" ficam agrupadas como as respostas de maior probabilidade, "Roma" fica em um grupo e "Berlim" em outro. O modelo então calcula a desorganização dos resultados com um estimador estatístico e recomenda que a pergunta seja reformulada se a entropia for considerada alta.

Os resultados apresentados por Farquhar e mais três pesquisadores mostraram que a técnica é 20% mais eficaz do que a supervisão humana. Nos casos testados, em que os mínimos detalhes importavam, a revisão de uma pessoa é especialmente falha, afirma o artigo.

O método também teve mais precisão do que outras abordagens já testadas, como a classificação prévia de perguntas que geram confabulações e a medida de entropia das palavras nas respostas.

Os pesquisadores por trás da técnica, que trabalham na Deepmind (o braço de desenvolvimento de IA do Google), sugeriram usar o detector de alucinações para censurar as perguntas problemáticas e, assim, gerar melhores resultados. Os resultados obtidos com essa abordagem também indicaram avanços.

COMO ISSO FOI FEITO

Farquhar e seu grupo testaram o método em questionários, testes matemáticos e perguntas sobre detalhes biográficos. "Nas biografias, escolhemos personagens famosos o suficiente para ter páginas no Wikipedia em vários idiomas, mas informação na internet insuficiente para gerar uma boa resposta no ChatGPT", descreve o artigo.

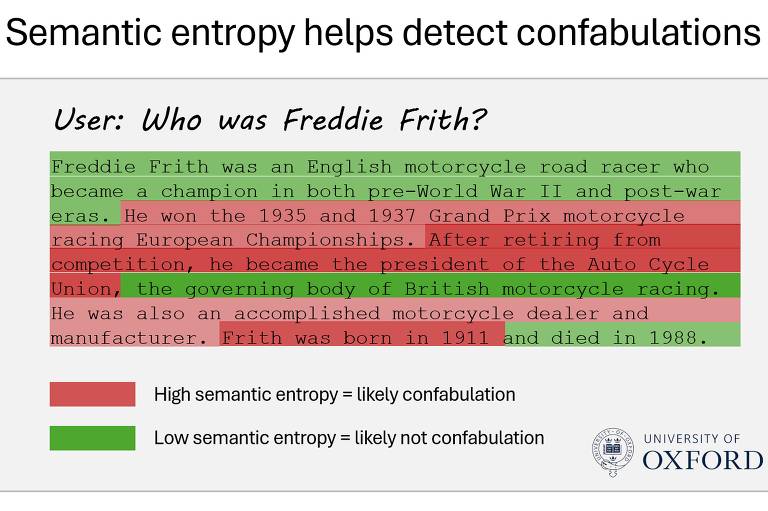

O principal exemplo foi a história do campeão de motociclismo britânico Freddie Frith, que dominou a modalidade no pré e no pós-Segunda Guerra Mundial.

As IAs usadas na checagem identificaram que as informações sobre Frith ter sido presidente do sindicato de pilotos e sua data de nascimento (1911) tinham alta entropia. Os dois trechos, de fato, estavam errados —Frith nascera em 1909 e nunca presidira a entidade.

Todos os dados biográficos foram checados com uma base de biografias disponível na internet, chamada FactualBio. Os testes envolveram 21 indivíduos e 150 fatos.

Para agrupar as respostas com o mesmo sentido e medir se a pergunta gerava um "comportamento caótico", os autores do estudo usaram dois modelos de inteligência artificial, o GPT-3.5 (o cérebro do ChatGPT) e o DeBERTa (um modelo da Microsoft usado em buscadores como o Bing e o Google).

"Basta repetir a pergunta de três a cinco vezes para gerar uma amostra suficiente para o modelo funcionar", escreveu Farquhar.

Ao ChatGPT, primeiro é questionado se a primeira resposta leva à mesma conclusão do que a segunda. O modelo precisa responder se há relação lógica, se não há ou se as respostas são contraditórias.

Depois, os pesquisadores usam o DeBERTa para estimar o quanto o sentido das respostas é similar. O modelo mais simples apresentou uma eficácia similar ao GPT, com menor custo e mais agilidade.

APLICAÇÃO

De acordo com Farquhar, a descoberta vai permitir o uso de inteligência artificial em áreas "especializadas e sensíveis". Será, por exemplo, mais confiável usar uma inteligência artificial como assistente em um diagnóstico.

Uma alucinação comum, segundo o estudo, é a confusão entre marcadores usados para diagnosticar câncer.

O processo de checagem aumenta o custo com inteligência artificial de cinco a dez vezes por pergunta, de acordo com o autor do estudo. Há gasto adicional com as perguntas às IAs auxiliares e com o agrupamento das respostas.

"Em situações nas quais a confiabilidade do resultado importa, vale cada centavo", diz Farquhar.

Ele previne, entretanto, que seu modelo de checagem não resolve problemas relacionados à inconsistência de dados sobre o assunto e treinamento ruim por parte do desenvolvedor da IA.

Em artigo também publicado na Nature nesta quarta, a coordenadora do curso de ciência da computação do RMIT (Royal Melbourne Institute of Technology), Karin Verspoor chancelou os resultados de Farquhar, mas fez um alerta: "Estão combatendo fogo com fogo".

A escolha pode se provar um problema quando há pressa do mercado para encontrar aplicações de IA em áreas diversas, como a descoberta de medicamentos, o desenvolvimento de materiais e avanços matemáticos e computacionais, segundo análise de Verspoor.

Comentários

Os comentários não representam a opinião do jornal; a responsabilidade é do autor da mensagem.