"All in all, it was just a brick in the wall" [Afinal, era só um tijolo na parede] —o refrão da canção clássica do Pink Floyd "Another Brick in the Wall" brotava de alto-falantes num laboratório de neurociência na Universidade da Califórnia em Berkeley, seus ritmos e palavras soando confusos, mas reconhecíveis.

A faixa não era uma gravação da banda de rock, mas uma gerada usando técnicas de inteligência artificial a partir das ondas cerebrais de pessoas que a ouviam, no primeiro experimento científico do mundo para reconstruir uma música identificável a partir de sinais neurais.

As descobertas serão inestimáveis tanto para cientistas que buscam entender como o cérebro responde à música quanto para neurotecnólogos que desejam ajudar pessoas com danos neurológicos graves a se comunicar por meio de interfaces cérebro-computador de uma maneira que soe mais natural, seja falando ou cantando.

"A música tem prosódia [padrões de ritmo e som] e conteúdo emocional", disse Robert Knight, professor de psicologia e neurociência da UC Berkeley, que liderou a pesquisa e cujas descobertas foram publicadas na revista PLOS Biology na terça-feira (15).

"À medida que todo o campo das interfaces cérebro-máquina avança, fornece uma maneira de adicionar tom e ritmo humanos a futuros implantes cerebrais para pessoas que precisam de canais para fala ou voz... Foi a partir disso que realmente começamos a decifrar o código", acrescentou Knight.

As gravações de eletroencefalografia (EEG) usadas na pesquisa foram obtidas por volta de 2012, numa época em que pessoas com epilepsia grave frequentemente tinham grandes conjuntos de eletrodos —normalmente 92 cada uma— colocados na superfície do cérebro para identificar a localização de convulsões intratáveis.

Os pacientes se ofereceram para ajudar na pesquisa científica ao mesmo tempo, permitindo que os pesquisadores gravassem suas ondas cerebrais enquanto escutavam fala e música.

Estudos anteriores baseados nesses experimentos forneceram aos cientistas dados suficientes para reconstruir palavras isoladas que as pessoas ouviam de gravações de sua atividade cerebral. Mas só agora, uma década depois, a IA se tornou poderosa o suficiente para reconstruir trechos de uma canção.

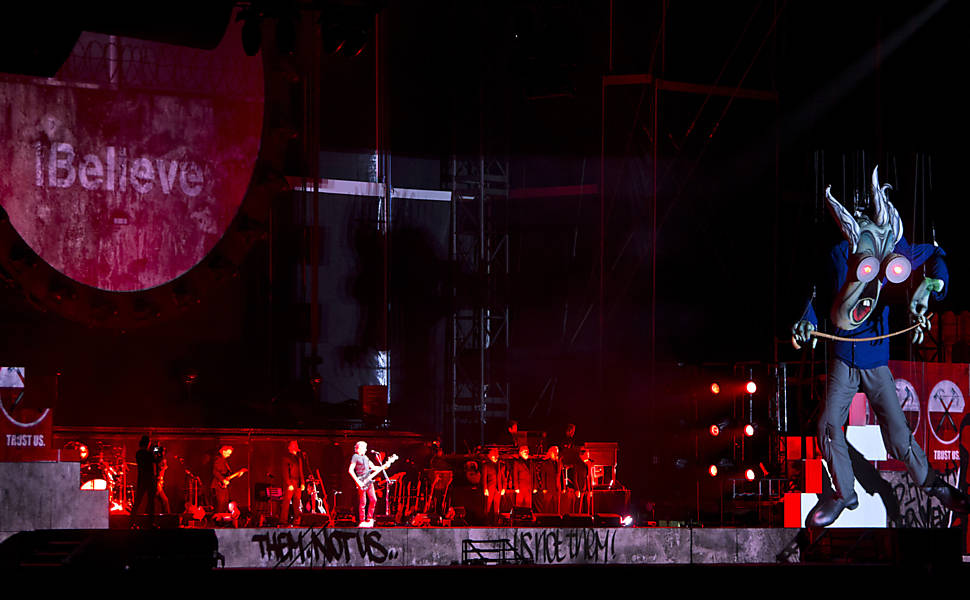

Os pesquisadores de Berkeley analisaram gravações de 29 pacientes que ouviram "Another Brick in the Wall (Parte 1)" do Pink Floyd, parte de uma trilogia de canções do álbum de 1979 "The Wall". Eles identificaram áreas do cérebro envolvidas na detecção do ritmo e descobriram que algumas partes do córtex auditivo, localizadas logo atrás e acima da orelha, respondiam ao início de uma voz ou sintetizador, enquanto outras respondiam a vocalizações sustentadas.

As descobertas confirmaram antigas ideias sobre os papéis desempenhados pelos dois hemisférios do cérebro. Embora trabalhem em estreita colaboração, a linguagem é processada predominantemente no lado esquerdo, enquanto "a música é mais distribuída, com viés para [a] direita", disse Knight.

Seu colega Ludovic Bellier, que liderou a análise, disse que os dispositivos usados para ajudar as pessoas a se comunicar quando não conseguem falar tendem a vocalizar as palavras uma a uma. As frases ditas pela máquina têm uma qualidade robótica que lembra a forma como o falecido físico Stephen Hawking soava em um dispositivo gerador de fala.

Queremos dar mais cor e liberdade expressiva à vocalização, mesmo quando as pessoas não estão cantando

"Queremos dar mais cor e liberdade expressiva à vocalização, mesmo quando as pessoas não estão cantando", disse Bellier.

Os pesquisadores de Berkeley disseram que a tecnologia de leitura cerebral pode ser ampliada a ponto de se decodificar os pensamentos musicais de uma pessoa usando um boné de EEG sobre o couro cabeludo, em vez de exigir eletrodos no cérebro, sob o crânio. Pode então ser possível imaginar ou compor música, retransmitir a informação musical e ouvi-la tocada em alto-falantes externos.

"Técnicas não invasivas ainda não são suficientemente precisas hoje", disse Bellier. "Esperamos que no futuro possamos, apenas a partir de eletrodos colocados fora do crânio, ler a atividade de regiões mais profundas do cérebro com uma boa qualidade de sinal."

Comentários

Os comentários não representam a opinião do jornal; a responsabilidade é do autor da mensagem.