O uso de filtros que clareiam a pele ou afinam o nariz e a predominância de fotos de pessoas brancas em pesquisas em bancos de imagem são exemplos do chamado racismo algorítmico.

Assim como uma receita de bolo, os algoritmos são instruções inseridas por um programador para que o sistema realize uma ação ou alcance determinado objetivo. Para funcionar bem, precisam ser permanentemente treinados com o uso de inteligência artificial, aprendizado de máquina e big data.

"É preciso quebrar o paradigma de que as tecnologias são neutras", afirma Tarcízio Silva, pesquisador e autor do livro "Racismo Algorítmico: Inteligência Artificial e Redes Digitais".

Para ele, o racismo algorítmico é em boa parte responsabilidade de quem produz tecnologia, uma vez que muitos desses códigos são criados por meio do aprendizado de máquina e se baseiam em experiências pessoais dos programadores que utilizam, em sua maioria, pessoas brancas em seus bancos de dados e na realização de testes.

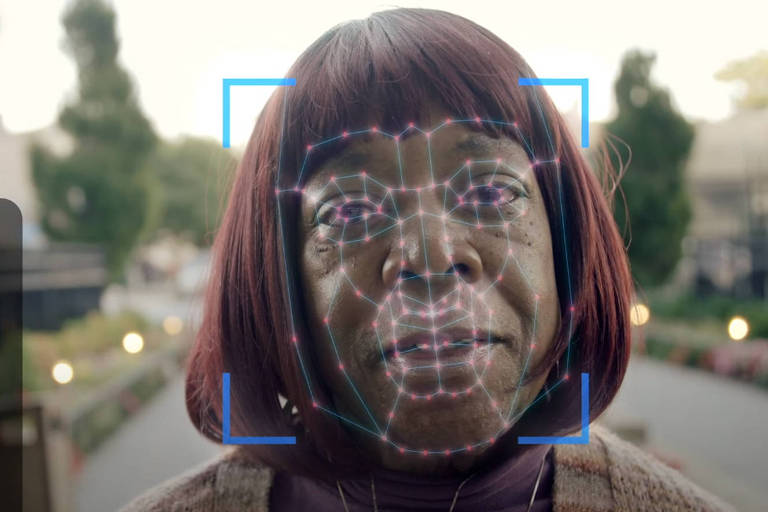

Um dos problemas é o uso de tecnologia de reconhecimento facial em casos policiais e investigações, uma vez que a maioria dos listados como suspeitos é negra, podendo levar a erros de identificação. Os aplicativos também apresentam dificuldades no reconhecimento de rostos negros.

Foi para combater as desigualdades presentes nas plataformas digitais que a pesquisadora Joy Buolamwini, do MIT (Massachusetts Institute of Technology), dos EUA, criou, em 2016, um projeto chamado Liga da Justiça Algorítmica.

A ideia nasceu quando Joy, que é negra, desenvolvia um protótipo de espelho inteligente capaz de reconhecer faces e projetar no reflexo rostos de pessoas inspiradoras.

Ao usar um algoritmo de reconhecimento facial, ela percebeu que seu próprio rosto não era detectado. Foi quando teve a ideia de pegar uma máscara branca de fantasia e ficar novamente de frente para o espelho. Dessa vez, o rosto foi reconhecido. Esse e outros exemplos com algoritmos de reconhecimento facial estão no documentário "Coded Bias" (Netflix).

A Liga visa, por meio da arte e da pesquisa, tornar o ecossistema algorítmico de aprendizagem das máquinas e IAs (inteligências artificiais) mais crítico, equitativo e responsável, além de aumentar a conscientização sobre as implicações sociais da ferramenta.

Para Silvana Bahia, codiretora executiva do Olabi e coordenadora do PretaLab, a iniciativa mostra ainda o quanto é preciso olhar para situações de opressão a partir das tecnologias digitais.

Nesse sentido, ela acredita que a inclusão de pessoas diversas nesse mercado é um caminho importante para a conscientização sobre os impactos do racismo algorítmico.

"Somente assim teremos a oportunidade de ter outras experiências, vivências que serão incorporadas no processo de desenvolvimento de determinado aplicativo ou na programação de uma sequência algorítmica", afirma.

No Brasil, algumas organizações sociais trabalham pensando a tecnologia de forma mais política e inclusiva, como o MariaLab, Minas Programam, Conexão Malunga e ITS Rio. Há ainda projetos como o próprio PretaLab, que oferece cursos de capacitação e fomenta uma rede que estabelece a conexão de mulheres negras com oportunidades no mercado de trabalho de tecnologia.

"Fazemos isso a partir de três pilares. O primeiro é a rede do nosso site, que reúne perfis de mais de 700 mulheres negras de diferentes áreas da tecnologia. O segundo são os cursos formativos, que buscam contribuir impulsionando a mobilidade profissional dessas mulheres. O terceiro é a conexão com o mercado de trabalho, que deseja ser mais inclusivo e tem procurado mais talentos", explica Silvana.

Ana Cláudia Santos, 53, inspirada pela filha que participou do PretaLab, decidiu arriscar e mudar de área profissional.

Formada em serviço social, ela diz que o entusiasmo da filha chamou a atenção, a levando a se inscrever no curso. "Quando fui selecionada, nem acreditei. Hoje estou muito feliz e acredito que, por meio de programas como esses, mulheres negras têm a oportunidade de se qualificar no mercado de tecnologia, assim como eu estou fazendo."

Outras formas de combater o racismo algorítmico, de acordo com o pesquisador Tarcízio, é ampliar as leis que regulam o uso dos dados.

"A LGPD (Lei Geral de Proteção de Dados) garante a privacidade das informações das pessoas tanto no meio físico quanto no digital, mas ainda é necessário incluir dispositivos antidiscriminatórios em leis sobre inteligência artificial, proteção de dados e estabelecer parâmetros para a área de segurança pública."

Comentários

Os comentários não representam a opinião do jornal; a responsabilidade é do autor da mensagem.