Pouco antes de o Dr. Bobby Mukkamala —um especialista em otorrinolaringologia em Michigan (Estados Unidos)— prescrever opioides após uma cirurgia, ele verificou os registros estaduais das prescrições de substâncias controladas de seu paciente, como exigido por lei. Uma pontuação gerada por um algoritmo proprietário apareceu em sua tela.

Conhecido como NarxCare —e agora usado pela maioria dos bancos de dados de monitoramento de prescrições estaduais, principais hospitais e cadeias de farmácias— o algoritmo indicava que seu paciente tinha um risco elevado de desenvolver uma dependência de analgésicos opioides.

"Causamos muita dor nas cirurgias", disse Mukkamala, que lidera uma força-tarefa sobre o uso de substâncias da Associação Médica Americana. "O nariz e o rosto são lugares muito sensíveis fazer procedimentos." Consequentemente, é difícil evitar a prescrição de opioides para controlar a dor.

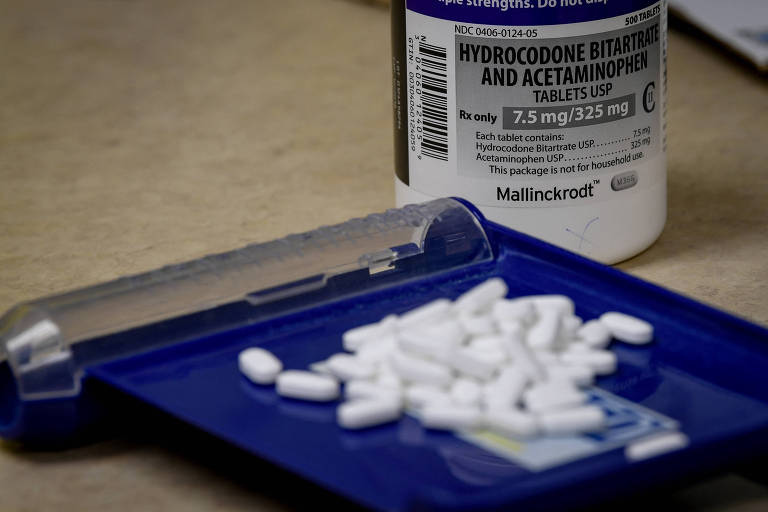

Algoritmos como o NarxCare e um teste genético recentemente aprovado para o risco de transtorno do uso de opioides, conhecido como AvertD, utilizam técnicas de "machine learning" para tentar ajudar os médicos a reduzir as chances de os pacientes se tornarem dependentes desses medicamentos.

Através do NarxCare, a maioria dos americanos agora tem um equivalente ao rating de crédito para substâncias controladas, que muitas vezes nem sabem que existe, a menos que um médico ou farmacêutico lhes diga que é um problema. (O fabricante do NarxCare afirma que suas pontuações e relatórios "são destinados a ajudar, não a substituir, a tomada de decisões médicas".)

Se o AvertD, promovido como uma maneira de usar a genética personalizada para avaliar o risco, se tornar amplamente utilizado, poderia colocar nos registros das pessoas ainda mais sinais de alerta que são difíceis de contestar.

Essas ferramentas podem ter boas intenções. Mas a prevenção da dependência é uma tarefa incrivelmente difícil. Apenas uma minoria das pessoas que tomam opioides se torna dependente, e os fatores de risco variam por motivos biológicos, psicológicos, sociológicos e econômicos.

Mesmo pontuações precisas podem causar danos, já que a dependência é estigmatizada e frequentemente criminalizada.

Algumas pessoas foram expulsas de consultórios médicos por terem pontuações altas no NarxCare, sem terem como recorrer da decisão. Outras foram negadas opioides pós-operatórios por enfermeiras ou rejeitadas por várias farmácias, com poucas alternativas.

Esses tipos de algoritmos podem potencialmente piorar os preconceitos raciais e de classe na tomada de decisões médicas. Não é difícil imaginar um futuro distópico de algoritmos sem transparência que tornem algumas pessoas permanentemente inelegíveis para o cuidado da dor com substâncias controladas.

Mukkamala observou que uma análise mais detalhada do histórico médico de seu paciente recente mostrou que na realidade não havia motivo para preocupação. "O que é inadequado é eu olhar para um indicador na escala e dizer: ‘Caramba, essa pessoa tem um problema. Eu não posso prescrever nada para a dor dela’", disse ele.

Muitos profissionais de saúde, no entanto, não têm o mesmo nível de conhecimento e confiança de Mukkamala. O preconceito contra pessoas com dependência é comum, assim como o medo de ser acusado de prescrição excessiva —e as pontuações dos algoritmos só alimentam essas preocupações.

Algoritmos diferentes, também sem transparência, monitoram os padrões de prescrição dos médicos e os comparam com os de seus colegas, então essa não é uma preocupação exagerada.

Quando escrevi pela primeira vez sobre o NarxCare em 2021 para a Wired, ouvi pacientes que foram deixados em agonia. Uma disse que seus opioides foram interrompidos no hospital e depois foi dispensada por seu ginecologista durante o tratamento para uma endometriose dolorosa por causa de uma pontuação alta na escala.

Ela não tinha um problema com drogas; sua pontuação parece ter sido elevada porque as prescrições para seus dois cães resgatados, que precisavam de tratamento médico, foram registradas em seu nome, fazendo parecer que ela estava fazendo "doctor shopping": consultando médicos diferentes para adquirir prescrições e medicamentos que não precisava.

Outro paciente com pontuação alta teve sua prescrição de medicamentos para tratamento da dependência negada repetidamente por farmácias —ainda que tais medicamentos sejam o único tratamento comprovado para reduzir o risco de overdose.

Pesquisas e reportagens mais recentes confirmam que as preocupações dos cientistas sobre o uso generalizado do software persistem e que os pacientes ainda relatam problemas devido a avaliações de risco potencialmente incorretas e aos receios dos membros da equipe médica de ignorar as pontuações do NarxCare.

Para gerar pontuações de risco, o NarxCare aparentemente utiliza variáveis como o número de médicos que alguém visita, as farmácias que frequentam e as prescrições que recebem, comparando os dados individuais com informações sobre padrões de comportamento associados ao "doctor shopping" e outros indicadores de possível dependência.

Mas não há transparência: o algoritmo do NarxCare é proprietário, e suas fontes de informação, dados de treinamento e variáveis de risco —e como são ponderadas— não são públicas.

Outro problema para o NarxCare é que a dependência de opioides é na verdade bastante incomum —afetando entre 2% e 4% da população adulta e adolescente, apesar do fato de que um estudo de 2016 mostra que cerca de 70% dos adultos foram expostos a opioides médicos.

"Identificar o risco básico de um indivíduo para o transtorno do uso de opioides é inerentemente muito difícil," disse Angela Kilby, uma economista que estudou algoritmos como o NarxCare quando era professora assistente na Universidade Northeastern. "É como procurar uma agulha no palheiro."

A raridade da condição possivelmente diminui a precisão do algoritmo, significando que a maioria dos resultados positivos pode ser falsamente positiva simplesmente porque a taxa básica do transtorno é baixa.

Pesquisas mostram que cerca de 20% das vezes, pessoas que são sinalizadas como "doctor shoppers" ao identificar fatores de risco semelhantes aos aparentemente incluídos no NarxCare na verdade têm câncer: elas geralmente consultam vários especialistas, frequentemente em centros de medicina acadêmica onde pode haver equipes de médicos fazendo prescrições.

O algoritmo não necessariamente consegue distinguir entre cuidados coordenados e "doctor shopping".

Da mesma forma, alguém que visita vários médicos ou farmácias e viaja longas distâncias pode estar procurando drogas —ou podem estar cronicamente doentes e incapazes de encontrar atendimento localmente.

Alguns estados também colocam informações de registros criminais em bancos de dados de monitoramento de prescrições, e isso pode levar a preconceitos contra pessoas negras e hispânicas simplesmente porque a discriminação racial significa que elas têm mais probabilidade de terem sido presas.

Há também um problema mais fundamental. Como Kilby observa, o algoritmo é projetado para prever elevações no risco de alguém desenvolver dependência de opioides ao longo da vida, não se uma nova prescrição mudará essa trajetória.

Por exemplo, se alguém já é dependente, uma nova prescrição não muda isso, e negá-la pode aumentar o risco de morte por overdose se a pessoa recorrer a drogas ilícitas.

Recentemente, o NarxCare foi acompanhado no jogo de previsão de dependência pelo AvertD, um teste genético que avalia o risco de transtorno por uso de opioides para pacientes que podem ser prescritos tais medicamentos, que a agência regulatória Food and Drug Administration (FDA) aprovou em dezembro passado.

Pesquisas do fabricante, Solvd Health, mostram que um paciente que desenvolverá dependência de opioides tem 18 vezes mais chances de receber um resultado positivo do que um paciente que não a desenvolverá.

O teste, que busca genes específicos associados a vias motivacionais no cérebro afetadas pela dependência, utiliza um algoritmo treinado com dados de mais de 7.000 pessoas, incluindo algumas com transtorno do uso de opioides.

Mas essa aprovação da FDA veio, surpreendentemente, após o comitê consultivo da agência para o teste ter votado esmagadoramente contra. Embora a FDA tenha trabalhado com a empresa por trás do teste para modificá-lo com base no feedback do comitê, ele continuou levantando preocupações.

E, recentemente, um grupo de 31 especialistas e cientistas escreveu para a FDA instando-a a reverter sua decisão e revogar sua aprovação. Algumas das preocupações do grupo ecoam os problemas com o NarxCare e seu algoritmo.

Para um estudo publicado em 2021, Alexander S. Hatoum, professor assistente de pesquisa em ciências psicológicas e cerebrais na Universidade Washington em St. Louis, e seus colegas avaliaram independentemente os elementos do algoritmo usados para uma ferramenta como o AvertD, com base em informações publicadas pela empresa.

Eles descobriram que todas as iterações que testaram foram confundidas pela estratificação populacional —um problema que afeta testes genéticos porque eles refletem a história da ascendência humana e como ela mudou ao longo do tempo devido a padrões de migração.

Quando o AvertD estava sendo considerado para aprovação pela FDA, o Hatoum e seus colegas escreveram um comentário público para a agência que dizia que as variantes genômicas usadas no teste estavam "altamente confundidas pela ascendência genética" e não previam o risco melhor do que o acaso quando a estratificação populacional não era levada em conta. (Em uma reunião de 2022, o CEO da Solvd afirmou que o AvertD se ajustava adequadamente à estratificação populacional; a FDA não respondeu diretamente a uma pergunta sobre essa afirmação.)

O trabalho do Dr. Hatoum também demonstrou que esses testes podem rotular erroneamente pessoas que são descendentes de dois ou mais grupos que historicamente estavam isolados um do outro como estando em risco de dependência. Como a maioria dos afro-americanos tem tal ascendência mista, isso poderia enviesar o teste para identificá-los como de alto risco.

"Isso significa que o modelo pode usar os marcadores genéticos do status afro-americano para prever o transtorno do uso de opioides, em vez de usar quaisquer marcadores genéticos biologicamente plausíveis," disse Marzyeh Ghassemi, professora do MIT que estuda aprendizado de máquina na saúde.

Em um email, a Solvd disse que em seu estudo clínico do AvertD, "não foram observadas diferenças no desempenho por raça, etnia ou gênero," acrescentando que estava realizando testes pós-comercialização conforme exigido pela FDA para avaliar ainda mais o teste.

A empresa também criticou a metodologia do Hatoum, dizendo que seu estudo "afirma uma premissa falsa."

A FDA disse em um comunicado que "reconhece que na tomada de decisões pré-mercado para dispositivos, geralmente existe alguma incerteza sobre benefícios e riscos," acrescentando que, no entanto, "determinou que há uma garantia razoável da segurança e eficácia do AvertD."

Ainda assim, a agência colocou um aviso de caixa preta no AvertD, proibindo seu uso em pacientes com dor crônica e enfatizando que o teste não pode ser usado sem consentimento do paciente.

Mas isso dificilmente será uma escolha de fato livre: os pacientes podem temer ser estigmatizados como potencialmente dependentes se não concordarem em ser testados. E falsos negativos que rotulam erroneamente alguém como de baixo risco podem, inversamente, levar a prescrições descuidadas.

Em meio à crise dos opioides, é compreensível que os reguladores queiram permitir tecnologias que possam reduzir o risco de dependência. Mas eles devem garantir que tais algoritmos e dispositivos sejam transparentes sobre seus métodos e limitações e que reduzam preconceitos raciais e outros —em vez de reforçá-los.

Comentários

Os comentários não representam a opinião do jornal; a responsabilidade é do autor da mensagem.