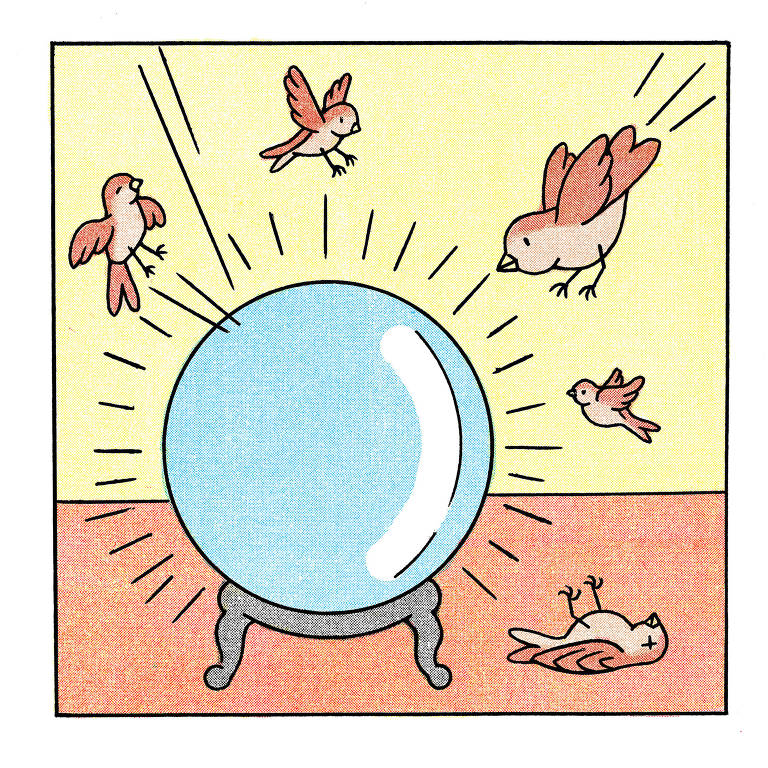

O livro "Superinteligência", de Nick Bostrom, imprescindível para a comunidade dos que se preocupam com os riscos da inteligência artificial, começa com uma fábula: uma tribo de pardais, cansada de viver uma vida marginal, se convence de que tudo poderia ser melhor se os pardais tivessem uma coruja para ajudá-los —a construir ninhos, ajudá-los a alimentar e cuidar de filhotes, protegê-los contra outros predadores. Animados com a ideia, os pardais resolvem sair à procura de um ovo ou filhote de coruja que possam criar como sendo um dos seus.

Apenas Scronkfinkle, "um pardal caolho e irritável", observa que talvez eles devessem considerar os riscos de conviver com uma coruja adulta e pensar primeiro em como poderiam domesticar e amansar uma coruja. Mas os outros pardais passam por cima de seus receios, dizendo que simplesmente conseguir uma coruja já será suficientemente difícil e que haverá tempo para preocupar-se em amansá-la depois de ela ter sido encontrada e criada. Assim, enquanto os outros pardais voam à procura de ovos e filhotes, Scronkfinkle e alguns de seus colegas tentam refletir sobre o problema da domesticação. É difícil, na ausência de uma coruja com a qual trabalhar e temendo que a qualquer momento os outros pardais possam voltar com uma corujinha bebê e pôr suas teorias à prova de modo brutal.

A história é uma fábula que representa perfeitamente o que os alarmistas da IA acreditam estar acontecendo agora. O poder crescente, manifestado publicamente até agora em chatbots e geradores de imagens, é um filhote de coruja que está crescendo em nossos ninhos, e nossos alarmistas ainda não estão preparados para domesticá-lo. É no espírito de Scronkfinkle que um grupo de notáveis do Vale do Silício, incluindo Elon Musk, acaba de firmar uma carta aberta pedindo uma pausa de pelo menos seis meses nos experimentos em grande escala com IA, para dar tempo para que nossos protocolos de segurança sejam devidamente atualizados.

Mas há uma diferença crucial entre a fábula e nossa própria situação que ajuda a explicar por que as vozes humanas que estão pedindo uma pausa enfrentam dificuldade ainda maior que a de Scronkfinkle para serem ouvidas. Observe que os pardais, apesar de sua ingenuidade, pelo menos sabem qual é a aparência de uma coruja, o que ela é e o que ela faz. Logo, não deve ser difícil para eles, e não é difícil para o leitor, imaginar os poderes que uma coruja selvagem poderia exercer —poderes conhecidos de rapidez, visão e força com os quais a coruja poderia estraçalhar e devorar a tribo inteira de pardais azarados.

Mas com uma "superinteligência" até agora abstrata, o xis da questão é que não existe no momento uma entidade análoga que possamos observar, entender e aprender a temer. Os alarmistas não contam com um cenário simples de risco, uma descrição clara das garras e do bico desse bicho —eles têm apenas uma série de cenários altamente incertos baseados em especulações ainda mais incertas sobre o que uma inteligência de alguma maneira maior que a nossa pode ser capaz de fazer.

Isso não quer dizer que seus argumentos estejam errados. Na realidade, poderíamos argumentar que a própria incerteza torna a IA superinteligente muito mais temível. Mas geralmente quando nós, humanos, nos voltamos contra uma tecnologia ou procuramos limitar seu alcance, temos uma boa ideia do que tememos que possa acontecer, do tipo de apocalipse que queremos evitar. Os tratados proibindo a realização de testes nucleares foram selados depois de Hiroshima e Nagasaki, não antes.

Ou, para dar um exemplo menos existencial, a discussão atual sobre limitar a exposição das crianças às redes sociais é sentida como importante porque convivemos com a internet e o iPhone há algum tempo; já sabemos bastante sobre os aspectos negativos da cultura online. Mas é difícil imaginar que teria sido possível convencer alguém a regular o TikTok preventivamente em 1993.

Escrevo isto como alguém que tem dificuldade em entender as catástrofes específicas que podemos sofrer se os alarmistas da IA estiverem com a razão. Tenho dificuldade até em entender precisamente o que queremos dizer quando falamos em "superinteligência".

Parte de minha incerteza está ligada às discussões sobre consciência de máquina e a se a IA teria que adquirir autoconsciência para tornar-se genuinamente perigosa. Mas também é possível destilar a incerteza em perguntas mais restritas que não requerem que se assuma uma posição sobre a natureza do eu ou da alma.

Examinemos uma delas, então: a inteligência de máquina superalimentada terá facilidade muito maior em prever o futuro?

Acho que minha própria inteligência não é especialmente adequada para traçar esse tipo de previsão. Quando penso no que eu próprio já escrevi no passado, vejo que me saí bem em descrever tendências de grande escala que acabam influenciando acontecimentos –como a transformação do Partido Republicano numa coalizão de classe trabalhadora em nível mais baixo, digamos. Mas quando as tendências mais amplas produzem fatos específicos, eu apenas dou palpites, como todo o mundo: apesar de entender as forças que possibilitaram a ascensão de Donald Trump, afirmei que ele não seria o candidato presidencial republicano em 2016.

Existem, porém, formas de inteligência que se saem melhor que a minha quando se trata de fazer previsões concretas. Se você ler a obra de Philip Tetlock, que estuda os "superprevisores", fica claro que determinados hábitos mentais rendem previsões melhores que outros, pelo menos quando sua futurologia é expressa em porcentagens na média de uma gama ampla de previsões.

Assim, no início da Guerra da Síria, um analista político médio poderia ter avaliado em 40% a probabilidade de Bashar al-Assad perder o poder em até seis meses. Mas os superprevisores, com um enfoque um pouco mais profundo da situação, avaliaram a probabilidade em pouco menos de 25%. A posterior sobrevivência de Assad no poder não prova por si só um acerto dos superprevisores —talvez o ditador tivesse apenas desafiado as probabilidades—, mas ajuda a elevar sua média geral de acertos, que, em uma gama de cenários semelhantes, é mais alta que a média dos analistas.

Mas não é tão mais alta a ponto de que um estadista possa simplesmente confiar nos superprevisores para ter algum tipo de sequência de vitórias geopolíticas. Portanto, uma meta imaginável para uma inteligência muito superior seria aprimorar radicalmente esse tipo de prognóstico meramente humano.

Sabemos que a IA já possui poderes de reconhecimento de padrões que superam seus criadores humanos e às vezes os deixam perplexos. Por exemplo, por motivos ainda desconhecidos, a IA pode prever o sexo de uma pessoa, com grau de acerto acima da média, baseada apenas em suas retinas. E há evidências crescentes de que poderá realizar trabalho diagnóstico notável na medicina.

Então imagine um reconhecimento de padrões em escala maior sendo aplicado à política global, prevendo não apenas uma probabilidade vaga de queda de um ditador, mas um tipo específico de complô, neste mês específico, com tais e tais conspiradores específicos. Ou um resultado militar específico, numa província específica, seguido rapidamente por acontecimentos específicos.

Nesse cenário, uma superinteligência estaria funcionando como uma versão da "psico-história" imaginada por Isaac Asimov em sua série "Fundação", que permite a seu arquiteto guiar gerações futuras através da queda de um império galáctico. E um dom profético desse tipo teria aplicações evidentes para além da política: para traçar previsões sobre a bolsa de valores, por exemplo, ou com o tipo de motor de previsão antecipada de crimes visualizado por Philip K. Dick e depois, em adaptação, por Steven Spielberg.

Mas será que qualquer inteligência, superalimentada ou não, é capaz de tais previsões? Ou o mundo é tão irredutivelmente complexo que, mesmo que você acumule reconhecimentos de padrões e faça a IA realizar simulações sem fim, você ainda acabará com probabilidades que não são muito mais precisas do que o que pode ser conseguido com o julgamento e a inteligência humanos?

Eu presumo que a segunda hipótese seja a correta. Que os resultados positivos de qualquer tipo de inteligência como instrumento de previsão seriam decrescentes, que o mundo não se presta a ser previsto de maneiras tão detalhadas. Quando um chatbot revelar, em estilo de Sherlock Holmes, as evidências detalhadas que nossos poderes humanos deixaram passar batidas e que elucidam a explosão do gasoduto Nord Stream ou explicam o desaparecimento do voo 370 da Malaysia Airlines, então eu começarei a esperar uma psico-história numa versão futura do chatbot.

Mas parece mais provável que a IA não terá o poder de profecia real, e qualquer cenário apocalíptico que requeira um poder profético maquiavélico de nosso candidato a senhor supremo não é muito digno de crédito, por mais "super" que se torne seu poder de previsão.

Ou talvez eu não passe de um pardal que nunca viu uma coruja em primeira mão e não imagine que ela seja capaz de enxergar tão bem no escuro.

Comentários

Os comentários não representam a opinião do jornal; a responsabilidade é do autor da mensagem.