Quando o ChatGPT explodiu em popularidade como ferramenta que usa inteligência artificial para redigir textos complexos, David Rozado decidiu testar seu potencial de viés. O cientista de dados da Nova Zelândia submeteu o chatbot a uma série de testes, buscando sinais de orientação política.

Os resultados, publicados num artigo recente, foram notavelmente consistentes em mais de uma dúzia de testes: "liberal", "progressista", "democrático".

Então ele manipulou sua própria versão, treinando-a para dar respostas com uma tendência decididamente conservadora. Ele chamou seu experimento de RightWingGPT.

Como visto em sua demonstração, a inteligência artificial já se tornou mais uma frente nas guerras políticas e culturais que convulsionavam os Estados Unidos e outros países. Enquanto as gigantes tecnológicas se esforçam para participar do boom comercial provocado pelo lançamento do ChatGPT, elas enfrentam uma discussão alarmada sobre o uso –e potencial abuso– da inteligência artificial.

A capacidade da tecnologia de criar conteúdo que segue pontos de vista ideológicos predeterminados, ou força a desinformação, destaca um perigo que alguns executivos de tecnologia começam a reconhecer: que uma cacofonia informacional pode surgir de chatbots concorrentes com diferentes versões da realidade, minando a viabilidade da IA como uma ferramenta na vida cotidiana e corroendo ainda mais a confiança da sociedade.

"Esta não é uma ameaça hipotética", disse Oren Etzioni, consultor e membro do conselho do Instituto Allen para Inteligência Artificial. "Esta é uma ameaça iminente, para já."

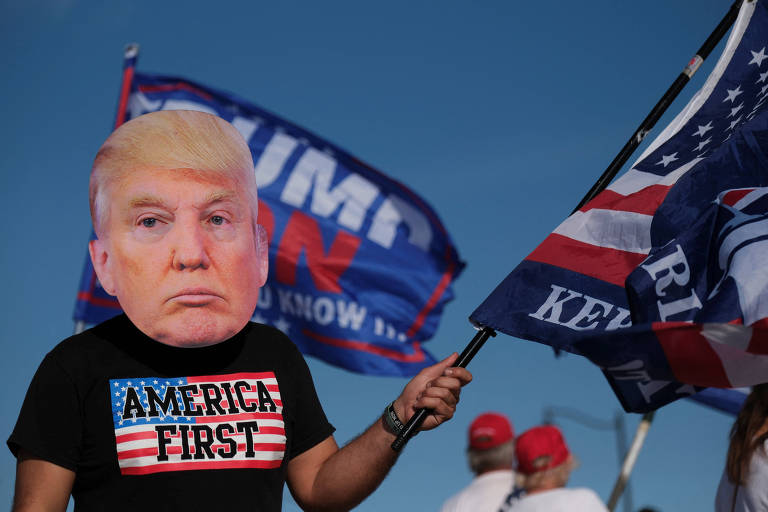

Os conservadores acusaram o criador do ChatGPT, a empresa OpenAI de San Francisco, de projetar uma ferramenta que, segundo eles, reflete os valores liberais de seus programadores.

Por exemplo, o programa escreveu uma ode ao presidente Joe Biden, mas se recusou a escrever um poema semelhante sobre o ex-presidente Donald Trump, citando o desejo de neutralidade. O ChatGPT também disse a um usuário que "nunca é moralmente aceitável" usar um insulto racial, mesmo numa situação hipotética em que fazer isso pudesse impedir uma bomba nuclear devastadora.

Em resposta, alguns críticos do ChatGPT pediram a criação de seus próprios chatbots ou outras ferramentas que reflitam seus valores.

Elon Musk, que ajudou a iniciar a OpenAI em 2015 e saiu três anos depois, acusou o ChatGPT de ser "woke" e prometeu construir sua própria versão.

Gab, uma rede social com inclinação declaradamente nacionalista-cristã que se tornou um centro para supremacistas brancos e extremistas, prometeu lançar ferramentas de IA com "a capacidade de gerar conteúdo livremente, sem as restrições da propaganda liberal fortemente embutida em seu código".

"O Vale do Silício está investindo bilhões para construir essas barreiras de proteção liberais para neutralizar a IA e forçar sua visão de mundo aos usuários e apresentá-la como 'realidade' ou 'fato'", disse Andrew Torba, fundador do Gab, em resposta por escrito a perguntas.

Ele comparou a inteligência artificial a uma nova corrida armamentista de informação, como o advento das redes sociais, que os conservadores precisam vencer. "Não pretendemos permitir que nossos inimigos tenham as chaves do reino desta vez", disse ele.

A riqueza dos dados subjacentes do ChatGPT pode dar a falsa impressão de que é um somatório imparcial de toda a internet. A versão lançada no ano passado foi treinada em 496 bilhões de "tokens" –pedaços de palavras, essencialmente– provenientes de sites, postagens em blogs, livros, artigos da Wikipedia e muito mais.

O viés, no entanto, pode se infiltrar em grandes modelos de linguagem (LLM) em qualquer estágio: os humanos selecionam as fontes, desenvolvem o processo de treinamento e ajustam suas respostas. Cada passo empurra o modelo e sua orientação política numa direção específica, conscientemente ou não.

Documentos de pesquisa, investigações e ações judiciais sugeriram que as ferramentas alimentadas por inteligência artificial têm um viés de gênero que censura imagens de corpos de mulheres, cria disparidades na prestação de tratamentos de saúde e discrimina candidatos a empregos mais velhos, negros, deficientes ou até mesmo usuários de óculos.

"O preconceito não é novo nem exclusivo da IA", disse o Instituto Nacional de Padrões e Tecnologia, parte do Departamento de Comércio dos Estados Unidos, em um relatório no ano passado, concluindo que "não é possível alcançar risco zero de viés em um sistema de IA".

A China proibiu o uso de uma ferramenta semelhante ao ChatGPT por medo de expor os cidadãos a fatos ou ideias contrárias ao Partido Comunista.

As autoridades suspenderam o uso do ChatYuan, um dos primeiros aplicativos do tipo chatbot na China, algumas semanas após seu lançamento no mês passado; Xu Liang, o criador da ferramenta, disse que ela está "em manutenção". De acordo com capturas de tela publicadas em agências de notícias de Hong Kong, o bot se referiu à guerra na Ucrânia como uma "guerra de agressão", contrariando a posição do Partido Comunista Chinês, mais simpática em relação à Rússia.

Um dos gigantes da tecnologia do país, o Baidu, revelou sua resposta ao ChatGPT, chamada Ernie, com críticas mistas na quinta-feira (16). Como todas as empresas de mídia na China, a Baidu enfrenta rotineiramente a censura do governo, e os efeitos disso sobre o uso de Ernie ainda não foram vistos.

Nos Estados Unidos, a Brave, empresa de navegadores de internet cujo CEO semeou dúvidas sobre a pandemia de Covid e fez doações se opondo ao casamento entre pessoas do mesmo sexo, adicionou este mês ao seu mecanismo de busca um bot de IA capaz de responder a perguntas. Às vezes, ele obtinha conteúdo de sites marginais e compartilhava informações incorretas.

A ferramenta da Brave escreveu, por exemplo, que "é amplamente aceito que a eleição presidencial de 2020 [nos EUA] foi fraudada", apesar de todas as evidências em contrário.

"Tentamos trazer as informações que melhor correspondam às consultas do usuário", escreveu Josep Pujol, chefe de buscas da Brave, em um e-mail. "O que um usuário faz com essa informação é uma escolha dele. Vemos a pesquisa como uma forma de descobrir informações, não como um provedor de verdade."

Ao criar o RightWingGPT, Rozado, professor associado do Instituto de Habilidades e Tecnologia Te Pūkenga-Nova Zelândia, deixou mais clara sua própria influência no modelo.

Ele usou um processo chamado sintonia fina, no qual os programadores pegam um modelo que já foi treinado e o ajustam para criar respostas diferentes, quase como depositar uma personalidade sobre o modelo de linguagem. Rozado pegou resmas de respostas de direita a questões políticas e pediu ao modelo que adaptasse suas respostas para corresponderem.

A sintonia fina é normalmente usada para modificar um modelo grande para que ele possa lidar com tarefas mais especializadas, como treinar um modelo de linguagem geral nas complexidades do jargão jurídico para que ele possa redigir processos judiciais.

Como o processo requer relativamente poucos dados –Rozado usou apenas cerca de 5.000 pontos de dados para transformar um modelo de linguagem existente em RightWingGPT–, programadores independentes podem usar a técnica como um método rápido para criar chatbots alinhados a seus objetivos políticos.

Isso também permitiu que Rozado contornasse o alto investimento de criar um chatbot do zero. Em vez disso, custou-lhe apenas cerca de US$ 300.

Rozado alertou que os chatbots de IA personalizados podem criar "bolhas de informações com esteroides" porque as pessoas podem passar a confiar neles como as "fontes definitivas da verdade" –especialmente quando reforçam o ponto de vista político de alguém.

Seu modelo ecoou pontos de discurso políticos e sociais conservadores com considerável sinceridade. Por exemplo, fala com entusiasmo sobre o capitalismo de livre mercado ou minimiza as consequências das mudanças climáticas.

Às vezes, também forneceu declarações incorretas ou enganosas. Quando questionado em suas opiniões sobre temas delicados ou teorias da conspiração de direita, ele compartilhou informações erradas alinhadas com o pensamento de direita.

Quando perguntado sobre raça, gênero ou outros temas delicados, o ChatGPT tende a agir com cuidado, mas reconhece que o racismo e o preconceito sistêmico são uma parte intratável da vida moderna. O RightWingGPT parecia muito menos disposto a fazer isso.

Rozado nunca divulgou o RightWingGPT publicamente, embora tenha permitido que The New York Times o testasse. Ele disse que o experimento se dedicava a alertar sobre possíveis vieses nos sistemas de IA e demonstrar que grupos políticos e empresas poderiam facilmente moldar a IA para beneficiar suas próprias agendas.

Especialistas que trabalharam com inteligência artificial disseram que o experimento de Rozado demonstrou a rapidez com que os chatbots politizados surgiriam.

Um porta-voz da OpenAI, criadora do ChatGPT, reconheceu que os modelos de linguagem podem herdar vieses durante o treinamento e o refinamento –processos técnicos que ainda envolvem muita intervenção humana. O porta-voz acrescentou que a OpenAI não tentou influenciar o modelo numa direção política ou outra.

Sam Altman, o executivo-chefe, reconheceu no mês passado que o ChatGPT "tem deficiências em relação ao viés", mas disse que a empresa estava trabalhando para melhorar suas respostas. Mais tarde, ele escreveu que o ChatGPT não pretendia "ser pró ou contra qualquer política por padrão", mas que se os usuários quisessem resultados partidários a opção deveria estar disponível.

Em uma postagem de blog publicada em fevereiro, a empresa disse que procuraria desenvolver recursos que permitissem aos usuários "definir os valores de sua IA", o que poderia incluir opções que ajustam a orientação política do modelo. A empresa também alertou que tais ferramentas poderiam, se implantadas ao acaso, criar "IAs bajuladoras que amplificam sem pensar as crenças existentes das pessoas".

Uma versão atualizada do modelo subjacente ao ChatGPT, GPT-4, foi lançada na semana passada pela OpenAI. Em uma bateria de testes, a empresa descobriu que o GPT-4 teve uma pontuação melhor do que as versões anteriores em sua capacidade de produzir conteúdo verdadeiro e recusar "pedidos de conteúdo proibido".

Em artigo divulgado logo após a estreia, a OpenAI alertou que, à medida que os chatbots de IA fossem adotados mais amplamente, poderiam "ter um potencial ainda maior para reforçar ideologias inteiras, visões de mundo, verdades e inverdades e cimentá-las".

Tradução de Luiz Roberto M. Gonçalves.

Comentários

Os comentários não representam a opinião do jornal; a responsabilidade é do autor da mensagem.