[RESUMO] Cada vez mais difundida, a inteligência artificial trouxe ganhos expressivos para a sociedade em geral, ao mesmo tempo que provoca receio por questões éticas envolvendo privacidade, discriminação e propagação de mentiras e golpes. É fundamental, portanto, que a sociedade seja capacitada para usufruir de seus benefícios e mitigar os efeitos deletérios.

Em palestra proferida em 1985, Richard Feynman, prêmio Nobel de 1965 e um dos mais reconhecidos físicos teóricos, debateu temas críticos do campo da IA (inteligência artificial). O diálogo com o público teve início com a pergunta-chave: "Haverá uma máquina que pode pensar como os humanos e ser mais inteligente que os humanos?".

Para Feynman, as futuras máquinas não pensarão como os seres humanos, da mesma forma que um avião não voa como os pássaros. Entre outras diferenças, os aviões não batem asas; são processos, dispositivos e materiais distintos. Quanto à questão de as máquinas superarem a inteligência humana, na visão do físico o ponto de partida está na própria definição de inteligência.

É difícil definir o que entendemos por inteligência. Segundo Stuart Russell, uma entidade é inteligente à medida que o que faz é capaz de alcançar o que deseja, ou seja, seus objetivos.

Escreve Russell: "Todas essas outras características da inteligência —perceber, pensar, aprender, inventar e assim por diante— podem ser compreendidas por meio de suas contribuições para nossa capacidade de agir com sucesso".

Russell lembra que o conceito de inteligência, desde os primórdios da filosofia grega antiga, está associado a capacidades humanas (perceber, raciocinar e agir), o que não seria o caso da IA, "mero" modelo de otimização com objetivos definidos pelos humanos e não dotado desses atributos.

Outros autores não consideram a inteligência uma prerrogativa humana, como o próprio Marvin Minsky, um dos fundadores desse campo de pesquisa, ao argumentar que os sistemas de IA têm habilidades, apesar de limitadas, de aprendizagem e raciocínio.

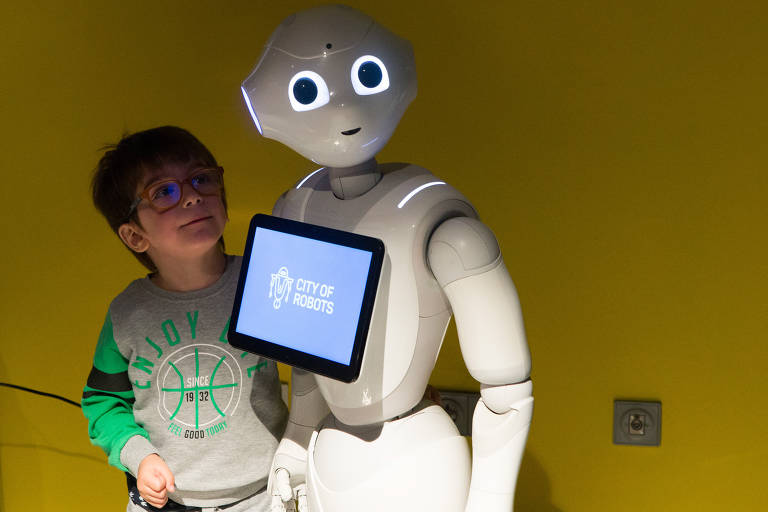

Complicando ainda mais esse debate, as técnicas atuais de IA lidam com percepção, análise de texto, processamento de linguagem natural, raciocínio lógico, sistemas de apoio à decisão, análise de dados e análise preditiva.

A inteligência artificial, campo de conhecimento inaugurado em 1956, é a ciência e a engenharia de criar máquinas capazes de reproduzir funções exercidas pelo cérebro biológico. Várias tentativas que envolviam linguagens formais apoiadas em regras de inferência lógica tiveram êxito limitado, sugerindo a necessidade de os sistemas gerarem seu próprio conhecimento pela extração de padrões de dados, ou seja, "aprender" com os dados sem receber instruções explícitas.

Esse processo é denominado de aprendizado de máquina ("machine learning"), subcampo da IA e hoje certamente o maior em número de praticantes. A técnica de aprendizado de máquina que apresentou os melhores resultados é a chamada de redes neurais de aprendizado profundo ("deep learning neural networks") pela inspiração no funcionamento do cérebro humano.

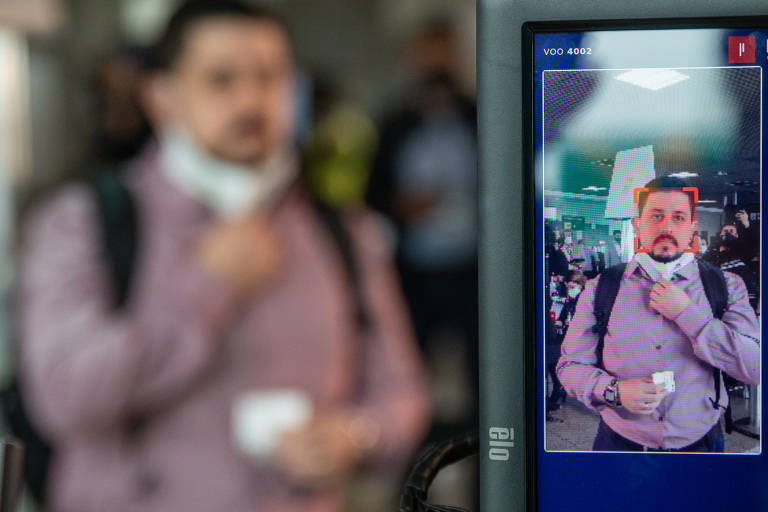

Na última década, a disponibilidade de grandes conjuntos de dados, produzidos por uma sociedade hiperconectada, e a maior capacidade computacional, particularmente com o advento das GPUs (unidades de processamento gráfico), geraram resultados positivos principalmente em visão computacional (reconhecimento de voz e imagem).

Essa técnica tornou-se fator estratégico de processos decisórios pela capacidade de gerar insights preditivos com taxas relativamente altas de precisão comparativamente às técnicas/modelos disponíveis.

Se, por um lado, o Brasil está atrasado em relação a outros países na pesquisa e no desenvolvimento da inteligência artificial, os brasileiros já convivem cotidiana e intensamente com os algoritmos de IA. São eles que viabilizam os modelos de negócios de empresas como Netflix, Waze, Spotify, Uber, Airbnb e iFood, dos games online, dos aplicativos de relacionamento.

A inteligência artificial otimiza processos no sistema financeiro e bancário, na indústria, na agricultura, no varejo, no setor imobiliário, na segurança e vigilância, no Poder Judiciário, na educação.

Na saúde, por exemplo, os dispositivos inteligentes transformam o corpo humano em plataforma tecnológica com marcapasso cardíaco monitorado remotamente, pâncreas artificial que controla a glicose no sangue e fornece insulina quando necessário, implantes cerebrais para lidar com os sintomas de Parkinson e Alzheimer.

O futuro da inovação passa por gerar valor alavancando a vasta quantidade de dados e técnicas de modelagem de IA, identificando insights ocultos, impulsionando o desenvolvimento de produtos e serviços e a experiência do usuário/cliente/consumidor.

Nesse sentido, é fundamental que os usuários intermediários —profissionais de saúde, de educação, gestores de RH, financeiros e gestores em geral— adquiram noções básicas da lógica e do funcionamento da IA para, inclusive, capacitar-se a fazer as perguntas críticas aos fornecedores de tecnologia. Os sistemas de inteligência artificial estão sendo empregados em larga escala sem a devida consciência dos potenciais riscos.

A adoção de sistemas de inteligência artificial não é trivial: demanda alterar os processos e a cultura da organização, ter equipe de colaboradores qualificados, garantir base de dados robustas e de qualidade e infraestrutura adequadas, entre outros pré-requisitos.

A implementação inclui questões de privacidade, opacidade e discriminação, inéditas interações humano-máquina e, mais relevante, os sistemas de IA geram simultaneamente externalidades positivas e negativas; o desafio é mitigar os potenciais danos sem eliminar junto os benefícios.

Vejamos dois exemplos.

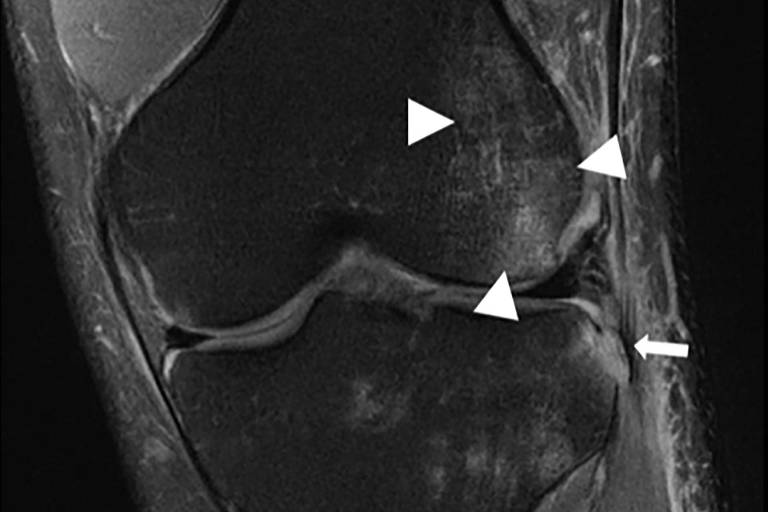

A GAN ("generative adversarial network"), uma das arquiteturas da técnica de redes neurais profundas, é combatida por gerar as chamadas deep fakes (tecnologia de inteligência artificial usada para criar conteúdos digitais falsos e convincentes, como áudio, imagens e vídeos em que uma pessoa se passa por outra), mas contribui positivamente em áreas como a saúde, ao criar dados sintéticos de qualidade suprindo a carência de dados para pesquisas médicas, e melhorando uma imagem de tomografia computadorizada ou ressonância magnética em baixa resolução (reduz o tempo de exposição, protegendo o paciente da radiação).

Os sistemas automatizados de decisão de crédito (atestam se o cliente da instituição financeira está ou não qualificado para receber o empréstimo solicitado), outro exemplo, explicitamente classificados pela proposta da Comissão Europeia como "sistemas de alto risco" e frequentemente criticados pela possibilidade de discriminação, são responsáveis, em parte, pela expansão do volume total de crédito ao contemplar um conjunto inédito de informações sobre o cliente, reduzindo o risco de inadimplência.

No Brasil, a base de crédito passou de R$ 1,7 trilhão em 2010 para R$ 3,22 trilhões em 2015 e R$ 4,57 trilhões em 2021, segundo o Banco Central.

No conjunto dos impactos sociais, o efeito negativo mais relevante é sobre o trabalho, ao transformar tarefas, empregos e habilidades. A automação inteligente acelerou o já em curso processo de substituição por máquinas de funções antes exercidas pelos seres humanos ao englobar funções cognitivas.

Uma parcela não desprezível dos empregos criados na próxima década será em ocupações totalmente novas ou alteradas por novos conteúdos e requisitos de competências. Esse conjunto de profissões emergentes reflete a adoção de novas tecnologias e a crescente demanda por novos produtos e serviços, impulsionadores de inéditos empregos na economia verde, na economia de dados, na economia do cuidado.

Para mitigar as consequências negativas da automação "inteligente", baseada nas tecnologias de IA, são essenciais políticas públicas com foco em investimentos em educação para qualificar e requalificar o trabalhador. O mercado de trabalho está migrando de especializado no século 20 para multidisciplinar no século 21, favorecendo a mobilidade entre funções, mas demandando atualização contínua.

Nos impactos éticos, destaca-se a discriminação algorítmica, que gera resultados tendenciosos por gênero, raça, etnia, entre outros. São múltiplas as origens de viés nos sistemas de IA: na geração dos dados, a discriminação está presente, por exemplo, na predominância de usuários dos países desenvolvidos com mais acesso a dispositivos, à tecnologia e à internet de qualidade, o que engendra uma base de dados imagética enviesada pelo biotipo racial de pele clara; em bases de dados tendenciosas, no caso dos dados coletados refletirem os preconceitos existentes na sociedade; na rotulagem dos dados, parte do aprendizado supervisionado utilizado, por exemplo, no reconhecimento de imagem e voz; e na interpretação dos resultados pelos usuários-gestores.

A "explicabilidade" é outro tema recorrente no debate sobre a inteligência artificial, figurando em destaque nas propostas de regulamentação mundo afora —os algoritmos estabelecem correlações nos dados não perceptíveis aos humanos, o que também é conhecido como problema de interpretabilidade, opacidade ou caixa preta.

O projeto de lei 21/2020, aprovado na Câmara, atualmente em tramitação no Senado, pretende estabelecer um marco legal da inteligência artificial no Brasil. Um de seus artigos propõe a obrigatoriedade de "implantar um sistema de inteligência artificial somente após avaliação adequada de seus objetivos, benefícios e riscos relacionados a cada fase" e, da mesma forma, encerrá-lo se o controle humano não for mais possível.

Na proposta da Comissão Europeia, o artigo 13 dispõe que "os sistemas de IA de alto risco devem ser concebidos e desenvolvidos de forma a garantir que o seu funcionamento seja suficientemente transparente para permitir aos utilizadores interpretar os resultados do sistema e utilizá-los de forma adequada" e complementa que "os sistemas de IA de alto risco devem ser acompanhados de instruções de uso em formato digital apropriado ou outro, que incluam informações concisas, completas, corretas e claras que sejam relevantes, acessíveis e compreensíveis para os usuários".

Além da quantidade de adjetivos do texto (suscetíveis a variadas interpretações, logo não precisos como requer uma lei), o conteúdo conflita com a natureza da IA. Os algoritmos de inteligência artificial são bons em identificar padrões estatísticos, mas eles não têm como saber o que esses padrões significam, porque estão confinados ao mundo da matemática —não compreendem o mundo real.

Diante dos extraordinários benefícios, não podemos nos dar ao luxo de rejeitar a tecnologia pelo desconforto de lidar com algo que não entendemos ou aceitar como neutra e soberana suas previsões.

Como alertam alguns especialistas, o perigo hoje não é que a IA seja mais inteligente que os humanos, mas supor que ela seja, e, consequentemente, confiar nela para tomar decisões importantes.

Comentários

Os comentários não representam a opinião do jornal; a responsabilidade é do autor da mensagem.