Na corrida frenética para construir sistemas de inteligência artificial generativa, o mantra da indústria de tecnologia tem sido quanto maior, melhor, e não importa o preço.

Agora as empresas de tecnologia estão começando a adotar tecnologias de IA menores, que não são tão poderosas, mas custam muito menos. E para muitos clientes, isso pode ser uma boa troca.

Nesta terça-feira (23), a Microsoft lançou três modelos simples, que fazem parte de uma família de tecnologia que a empresa chamou de Phi-3.

A empresa disse que até o menor dos três modelos teve um desempenho quase tão bom quanto o GPT-3.5, um sistema muito maior que sustentava o chatbot ChatGPT da OpenAI quando surpreendeu o mundo em seu lançamento no final de 2022.

O menor modelo Phi-3 pode caber em um smartphone, então pode ser usado mesmo que não esteja conectado à internet. E pode ser executado nos tipos de chips que alimentam computadores padrão, em vez de processadores mais complexos e caros feitos pela Nvidia.

Como os modelos menores exigem menos processamento, os grandes provedores de tecnologia podem cobrar menos dos clientes para usá-los. Eles esperam que isso signifique que mais clientes possam usar IA onde os modelos maiores e mais avançados têm sido muito caros.

Embora a Microsoft tenha dito que usar os novos modelos seria "substancialmente mais barato" do que usar modelos como o GPT-4, ela não ofereceu detalhes.

Os sistemas menores são menos poderosos, o que significa que podem ser menos precisos ou soar mais desajeitados. Mas a Microsoft e outras empresas de tecnologia estão apostando que os clientes estarão dispostos a abrir mão de parte do desempenho se isso significar que eles poderão pagar pela IA.

Os clientes imaginam muitas maneiras de usar a IA, mas com os maiores sistemas "eles pensam, 'Ah, mas você sabe, eles podem ficar meio caros'", disse Eric Boyd, um executivo da Microsoft. Modelos menores, quase por definição, são mais baratos de implantar, ele disse.

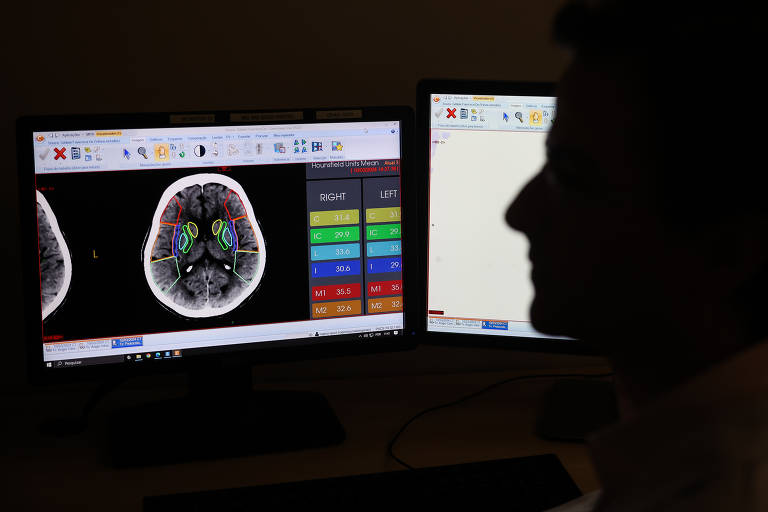

Boyd disse que alguns clientes, como médicos ou preparadores de impostos, poderiam justificar os custos dos sistemas de IA maiores e mais precisos porque o tempo deles era tão valioso. Mas muitas tarefas podem não precisar do mesmo nível de precisão. Anunciantes online, por exemplo, acreditam que podem segmentar melhor os anúncios com IA, mas precisam de custos mais baixos para poder usar os sistemas regularmente.

"Eu quero que meu médico acerte as coisas", disse Boyd. "Outras situações, como resumir avaliações de usuários online, se estiver um pouco errado, não é o fim do mundo."

Os chatbots são impulsionados por grandes modelos de linguagem, ou LLMs, sistemas matemáticos que passam semanas analisando livros digitais, artigos da Wikipedia, artigos de notícias, registros de chat e outros textos coletados em toda a internet. Ao identificar padrões em todo esse texto, eles aprendem a gerar texto por conta própria.

Mas os LLMs armazenam tantas informações que recuperar o que é necessário para cada chat requer considerável poder de computação. E isso é caro.

Enquanto gigantes da tecnologia e startups como a OpenAI e a Anthropic têm se concentrado em melhorar os maiores sistemas de IA, eles também estão competindo para desenvolver modelos menores que ofereçam preços mais baixos. Meta e Google, por exemplo, lançaram modelos menores ao longo do último ano.

Meta e Google também abriram os códigos desses modelos, o que significa que qualquer pessoa pode usá-los e modificá-los gratuitamente.

Esta é uma maneira comum para as empresas obterem ajuda externa para melhorar seu software e incentivar a indústria em geral a usar suas tecnologias. A Microsoft também está disponibilizando seus novos modelos Phi-3 como open source.

Depois que a OpenAI lançou o ChatGPT, Sam Altman, CEO da empresa, disse que o custo de cada chat era de "centavos de dólar" — um enorme gasto considerando o que serviços web populares como a Wikipedia estão servindo por frações de centavos.

Agora, os pesquisadores dizem que seus modelos menores podem pelo menos se aproximar do desempenho de principais chatbots como ChatGPT e Google Gemini.

Essencialmente, os sistemas ainda podem analisar grandes quantidades de dados, mas armazenam os padrões que identificam em um pacote menor que pode ser servido com menos poder de processamento.

Construir esses modelos é um equilíbrio entre poder e tamanho. Sébastien Bubeck, pesquisador e vice-presidente da Microsoft, disse que a empresa construiu seus novos modelos menores refinando os dados que foram inseridos neles, trabalhando para garantir que os modelos aprendessem com textos de maior qualidade.

Parte desse texto foi gerado pela própria IA — o que é conhecido como "dados sintéticos". Em seguida, curadores humanos trabalharam para separar o texto mais afiado do restante.

A Microsoft construiu três modelos pequenos diferentes: Phi-3-mini, Phi-3-small e Phi-3-medium. O Phi-3-mini, que estará disponível na terça-feira, é o menor (e mais barato) mas o menos poderoso. O Phi-3 Medium, que ainda não está disponível, é o mais poderoso, mas é o maior e mais caro.

Tornar os sistemas pequenos o suficiente para ir diretamente para um telefone ou computador pessoal "os tornará muito mais rápidos e menos caros", disse Gil Luria, analista do banco de investimento D.A. Davidson.

Comentários

Os comentários não representam a opinião do jornal; a responsabilidade é do autor da mensagem.